データセンター光相互接続ソリューション

光データセンター相互接続インフラストラクチャは、主にスイッチとサーバーで構成されますが、光ファイバーケーブルと光トランシーバー、またはアクティブな光ケーブルと直接接続ケーブルも接続に使用されます。データセンターでは、トラフィックの爆発的な増加により、光トランシーバのデータレートがエスカレートおよび加速されています。 10Gから40Gまで5年、40Gから100Gまで4年かかりましたが、100Gから400Gまでは3年しかかかるかもしれません。将来のデータセンターのすべてのエクスポートデータは、内部の大規模運用(特に、AI、VR / AR、UHDビデオなどの内部およびエクスポートフローの増加)を通過する必要があります。データセンター内の東西方向の流れは乱流であり、フラットなデータセンターアーキテクチャにより、100G光トランシーバー市場は高速で成長し続けています。

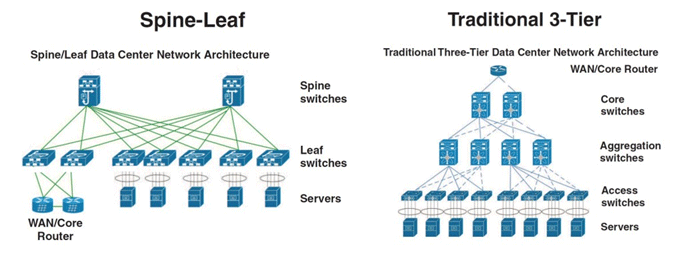

従来の3層データセンターのメインデータフローの方向は上から下、または南から北です。一方、フラットスパインリーフデータセンターのメインデータフローの方向は東から西です。

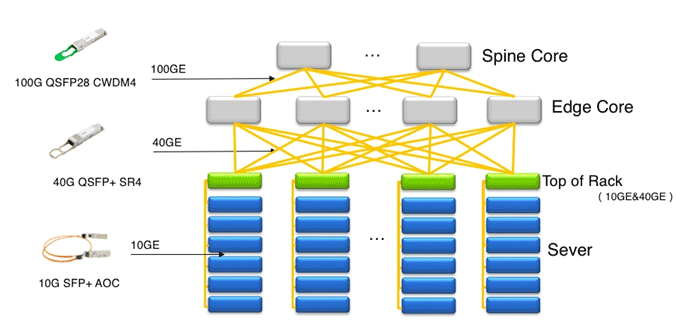

以下は、光トランシーバーとAOCのデータセンター光相互接続アプリケーションのケースです。クラウドデータセンターのネットワークアーキテクチャは、Spine Core、Edge Core、およびToR(Top of Rack)に裏打ちされています。 10G SFP + AOCは、ToRアクセススイッチとサーバーNIC間の相互接続に使用されます。 ToRアクセススイッチとEdge Coreスイッチ間の相互接続には、40G QSFP + SR4光トランシーバーとMTP / MPOケーブルが使用されます。 Edge CoreスイッチとSpine Coreスイッチ間の相互接続には、100G QSFP28 CWDM4光トランシーバーと二重LCケーブルが使用されます。

| アップグレードパス | 2008–2014 | 2013–2019 | 2017–2021 | 2019~ |

| データセンターキャンパス | 40G-LR4 | 40G-LR4 100G-CWDM4 | 100G-CWDM4 | 200G-FR4 |

| 建物内 | 40G-eSR4 4x10G-SR | 40G-eSR4 | 100G-SR4 | 200G-DR4 |

| ラック内 | CAT6 | 10G AOC | 25G AOC | 100G AOC |

| サーバーデータレート | 1G | 10G | 25G | 100G |

クラウドデータセンターのトラフィックの増加率、ネットワークアーキテクチャ、信頼性の要件、およびコンピュータールーム環境とキャリアクラスのネットワークの違いにより、クラウドデータセンターの光モジュールの需要は次の特性を反映しています:短い反復サイクル、高レート、高密度、低消費電力、 大規模。

短い反復期間

データセンターのトラフィックの急速な増加は、光トランシーバーの高速化を促進しています。光トランシーバーを含むデータセンターハードウェアデバイスの反復期間は約3年で、通信光トランシーバーの反復期間は通常6〜7年です。

より高速

データセンターのトラフィックが爆発的に増加するため、光トランシーバーのテクノロジーイテレーションは需要に追いつくことができず、ほとんどすべての最先端テクノロジーがデータセンターに適用されます。 より高速の光トランシーバの場合、常にデータセンターに対する需要があり、重要な問題は、技術が成熟しているかどうかです。

高密度

高密度コアは、本質的に、スイッチおよびサーバーの単一ボードの伝送容量を改善して、高速で増加するフローの需要を満たすことです。 同時に、密度が高いほど、配置する必要があるスイッチが少なくなり、機械室のリソースを節約できます。

低消費電力

データセンターの消費電力は非常に大きくなります。 低消費電力は、エネルギーを節約し、より良い熱放散を確保することです。 データセンターのバックボードには光トランシーバーがいっぱいあるため、放熱の問題を適切に解決できない場合、光トランシーバーのパフォーマンスと密度が影響を受けます。